Дисплей с VRR (Variable Refresh Rate) может в реальном времени регулировать частоту обновления экрана для её синхронизации с источником сигнала. Как правило, это игровая консоль или ПК, но это может быть и видеоплеер. VRR поддерживается на ПК, Xbox One S/X и Xbox Series S/X, а также Sony PlayStation 5 (после недавнего обновления).

Это контрастирует с фиксированной частотой обновления, являющейся нормой для телевизоров, которые исторически обновлялись с частотой 60 или 120 Гц в Северной Америке (и других регионах NTSC) и 50 или 100 Гц в Европе (и других регионах PAL). Современные телевизоры могут обновляться со всеми этими фиксированными частотами обновления — а иногда и с другими частотами обновления — в зависимости от исходного сигнала.

Однако игра, запущенная на игровой консоли или ПК, не всегда имеет фиксированную частоту кадров. Некоторые игры работают с «разблокированной» частотой кадров, что и требуется для использования преимуществ VRR . Конкретная игра может работать со скоростью 120 кадров в секунду в диалоговых сценах, но снижаться до 50 кадров в секунду или ниже в экшн сценах. Настройка ПК или игровой консоли для вывода изображения в режиме VRR через HDMI сообщает совместимому телевизору, что он также должен работать в режиме VRR , то есть регулировать частоту обновления в режиме реального времени, чтобы соответствовать выходному сигналу источника в любой момент времени.

VRR для Sony. Свергнет ли это LG OLED со звания лучшего игрового телевизора? | ABOUT TECH

VRR обеспечивает такие преимущества, как устранение «разрывов» (когда изображение ненадолго разбивается на два сегмента), снижение «input lag»-а (время между нажатием кнопок и действием на экране) и более плавный игровой процесс с уменьшением дрожания. VRR также облегчает разработчикам игр переход свыше 60 кадров в секунду(поскольку даже 70-80 кадров в секунду представляют собой заметное улучшение). Без VRR разработчикам игр пришлось бы переходить к фиксированному режиму вывода 100 или 120 Гц.

ОБЫЧНЫЙ V-SYNC (И ФИКСИРОВАННАЯ ЧАСТОТА ОБНОВЛЕНИЯ) В СРАВНЕНИИ С ADAPTIVE/VARIABLE SYNC

Режим VRR в телевизорах

К сожалению, VRR сегодня не лишен недостатков. В ЖК-телевизорах система локального затемнения либо полностью отключена, либо критически ослаблена, поскольку локальное затемнение требует анализа изображения, что способствует задержки изображения, а это работает только с пакетными медиа (фильмы, сериалы и т.д.).

Фактически это означает, что современный ЖК-телевизор в режиме VRR более или менее сводится к обычному ЖК-телевизору без локального затемнения с гораздо более низкой контрастностью. Многие ЖК-телевизоры недостаточно быстры, время отклика слишком медленное, чтобы в полной мере использовать преимущества 60 кадров в секунду+.

OLED-телевизоры лучше подходят для VRR , поскольку они имеют гораздо более высокую собственную контрастность, гораздо более быстрое время отклика и управление светимостью/цветностью на уровне пикселей, но режим VRR все равно может вызвать повышение черного и мерцание в играх с низкой частотой кадров из-за того, что телевизоры были изначально оптимизированы для 120 Гц.

VRR на Sony X95J, A90J и Samsung QN90A! Качество изображения отличное, НО | ABOUT TECH

Как правило, для достижения наилучшего качества изображения и впечатлений от работы в режиме VRR , необходимо, чтобы данный дисплей использовал как можно меньше таких функций, как локальное затемнении. Это связано с тем, что в режиме VRR панель телевизора отключает большинство своих обработок. Мы рекомендуем для игр с VRR технологию самоизлучающих дисплеев, например, WOLED, QD-OLED или microLED.

Следует также отметить, что не многие AV-ресиверы или саундбары поддерживают сквозную передачу VRR, поэтому следует стремиться подключать ПК или консоль непосредственно к порту HDMI 2.1 телевизора, а затем использовать выход HDMI eARC телевизора для передачи звука на ресивер/саундбар.

АКТИВАЦИЯ VRR НА XBOX МОЖЕТ ПОВЫСИТЬ УРОВЕНЬ ЧЕРНОГО КАК НА LCD, ТАК И НА OLED ТЕЛЕВИЗОРАХ (НА ФОТО LG GX). В GEARS 5 ВЫ МОЖЕТЕ ИСПОЛЬЗОВАТЬ ЭТУ СЦЕНУ ИЗ ПЕРВОЙ ГЛАВЫ, ЧТОБЫ УВИДЕТЬ РАЗНИЦУ С АКТИВИРОВАННЫМ И ДЕАКТИВИРОВАННЫМ VRR НА XBOX

Три формата VRR

На рынке телевизоров существует три вида VRR:

- HDMI 2.1 VRR

- AMD FreeSync

- Nvidia G-Sync Compatible

Системы AMD и Nvidia уже много лет работают по стандарту DisplayPort. Новым достижением стало то, что теперь они также работают через HDMI 2.1 (FRL) с частотой до 4K 120 Гц. Системы улучшения, такие как LFC (компенсация низкой частоты кадров), зависят от источника.

Важно принимать во внимание частотный диапазон. Если у данной модели телевизора частотный диапазон 48-120 Гц, это означает, что панель может обновлять изображение только при частоте 48 Гц или выше (до 120 Гц). Если, например, в игре частота кадров упадет до 46 кадров в секунду, вы уже не сможете получить все преимущества VRR . Так же не все телевизоры с поддержкой HDMI 2.1 поддерживают VRR .

Источник: dzen.ru

Что такое G-Sync, FreeSync, V-Sync и HDMI VRR? — Разбор

Всех ПК-геймеров планеты Земля, да и консольных игроков тоже, объединяет одна проблема — вертикальные разрывы изображения. И вроде бы есть куча технологий которые решают эту проблему:

- V-Sync,

- G-Sync,

- FreeSync

- А ведь еще есть Adaptive Sync

- А в HDMI 2.1 недавно добавили VRR.

Давайте сегодня раз и навсегда разберемся в технологиях адаптивной синхронизации изображения.

Для тех кто не в курсе. А в чём собственно проблема?

Чтобы изображение появилось на экране, должно произойти, как минимум, две вещи:

- графический процессор должен подготовить кадр и передать его на монитор,

- ваш монитор должен показать этот кадр.

Обычные мониторы работают на частоте 60 Гц, то есть способны выводить 60 кадров в секунду, а игровые на 144 Гц и выше.

А вот графический процессор живет в совершенно ином мире. В играх постоянно всё меняется: колышется листва, журчит ручеёк, враги выпрыгивают из-за угла. Каждый кадр отличается по своей сложности, поэтому на их просчет уходит разное количество времени.

Иными словами, у монитора частота кадров постоянная, а у видеокарты переменная.

Вот и выходит, что за один цикл обновления монитора видеокарта может подготовить больше одного кадра или меньше.

Из-за этого мало того что страдает плавность картинки, так еще и появляются артефакты в виде вертикальных разрывов изображения. Кстати, при просмотре фильмов тоже могут появляться такие артефакты, потому что кино снимают в 24 к/с.

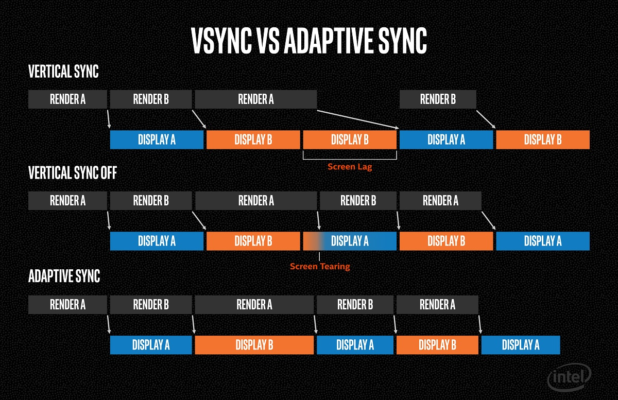

V-Sync

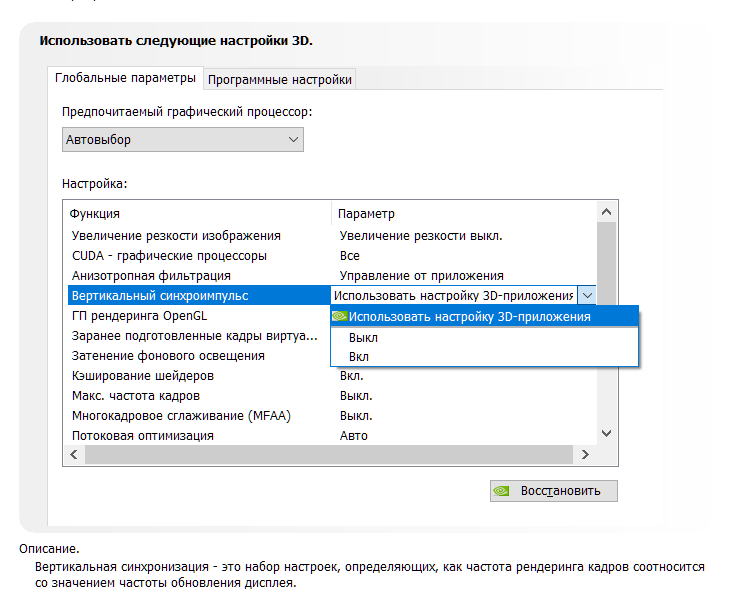

Очевидно проблема требовала решения, и еще на заре компьютерных игр оно появилось! Название у этого решения — вертикальная синхронизация или V-Sync. Наверняка вы встречали такую опцию как в настройках видеокарты, так и в играх.

Работает эта штука достаточно топорно. Фактически она просто принуждает видеокарту выводить кадры с частотой кратной частоте обновления экрана. Например, если у вас монитор 60 Гц, то максимальное количество кадров в секунду тоже будет 60, даже если ваша видеокарта способна на большее. И в общем-то часто такое ограничение вполне уместно, если у видеокарты хватает мощи и нет просадок ниже 60 к/с, но если они есть — начинаются проблемы.

При включенной вертикальной синхронизации, следующее кратное значение — это 30 к/с. Поэтому даже если ваш фреймрейт просел фактически всего на пару кадров, вы всё равно увидите падение до 30 к/с. Такой перепад мало того, что большой и очень визуально ощутимый, так ещё и будет происходить с небольшим лагом. Поэтому если стабильного FPS в 60 к/с или 30 не достичь, то включать V-Sync вообще нет никакого смысла.

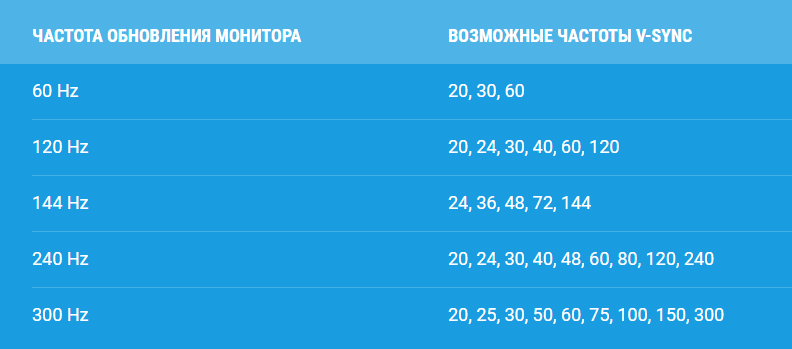

Справедливости ради, чем выше герцовка монитора, тем больше мы имеем кратных значений, на которых может работать синхронизация. Поэтому на игровых мониторах V-Sync работает куда лучше.

Но история с кратными значениями — не самая главная проблема технологии. Есть другой неочевидный недостаток: вертикальная синхронизация — увеличивает задержку ввода, то есть создаёт Input Lag.

Игра медленнее реагирует на ваши действия, всё происходит с задержками и как-то плывёт в молоке, поэтому прицелиться становится гораздо сложнее. Почему так происходит?

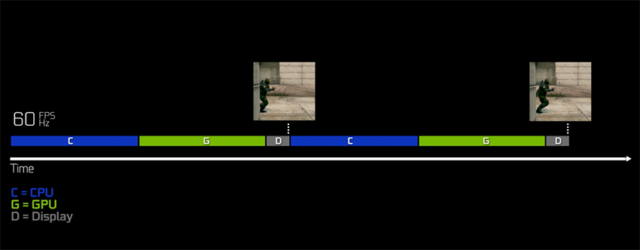

Это интересно, смотрите! Каждый кадр рассчитывается и выводится на экран через один и тот же конвейер. Упростим его до трёх этапов.

- Каждое ваше действие, например щелчок мышки надо как-то интерпретировать и обновить состояние игры. За это отвечает центральный процессор (синяя полоса на картинке ниже). Центральный процессор подготавливает кадры для графического процессора и помещает их в очередь рендеринга графического процессора.

- Затем графический процессор (зелёная полоса) берет эти подготовленные кадры из очереди и рендерит их.

- Только потом эти кадры выводятся на дисплей (серая полосочка на картинке).

Ну и в чём проблема, спросите вы? Дело в том, что ЦП не берется за подготовку следующего кадра, пока предыдущий не будет выведен на экран. Поэтому ограничивая количество выводимых кадров в угоду синхронизации с дисплеем, мы фактически увеличиваем задержки с которыми обновляется состояние игры! И если в каких-то простеньких играх типа пасьянса такие вещи допустимы, то в соревновательных играх вертикальная синхронизация может стать серьёзной помехой.

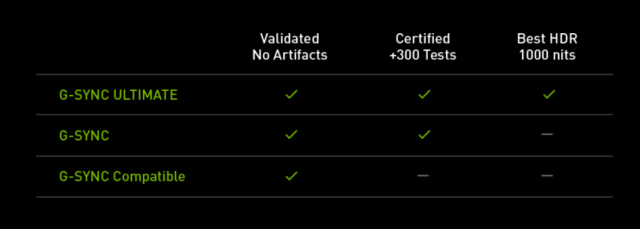

G-Sync

Но переживать не стоит, так как решение появилось еще в 2013 году. Именно тогда компания NVIDIA представила свою технологию адаптивной синхронизации — G-Sync. В отличие от старой технологии, G-Sync позволяет подстраивать не видеокарту под частоту обновления монитора, а наоборот заставляет монитор менять свою частоту под видеокарту!

Представляете? Так тоже можно было!

В результате мы получаем потрясающе плавную картинку без вертикальных разрывов и задержки ввода! Просто сказка! G-Sync также работает в огромном диапазоне частот. Изначально это было от 30 до 144 Гц, а сейчас уже есть поддержка до 360 Гц и может даже выше, тут скорее всё зависит от монитора.

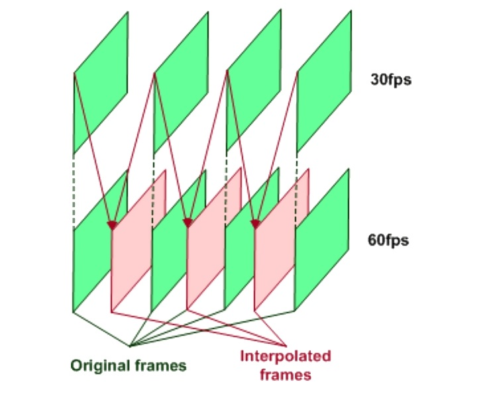

А если фреймрейт падает ниже 60 Гц G-Sync умеет дублировать пропущенные кадры.

Получаются сплошные плюсы и проблема решена еще в 2013 году? Так почему же мы до сих пор об этом говорим?

Ну как сказать. Во-первых, эта технология закрытая, соответственно, G-Sync работает только с карточками NVIDIA, но это пол беды.

Все волшебные функции G-Sync стали возможны благодаря специальному чипу, который необходимо встроить в монитор. Естественно, эти чипы производит тоже NVIDIA и стоят они недешево. Поэтому мониторы с поддержкой G-sync в среднем стоят на 250-300$ дороже и таких моделей очень мало. То есть получилась классная, и для 2013 года революционная технология, но не универсальная и дорогая.

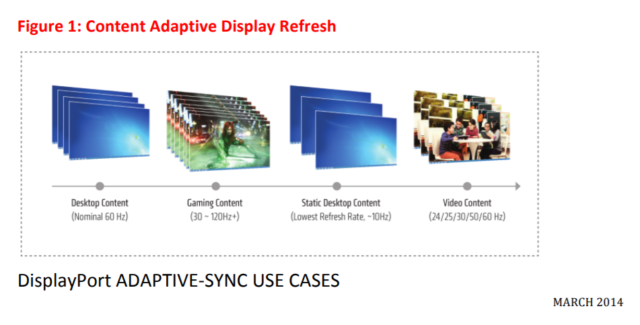

VESA Adaptive Sync

Поэтому уже спустя год, в 2014, Ассоциация стандартизации Video Electronics Standards Association или VESA представила открытую технологию Adaptive Sync, которая умеет, в принципе, всё то же самое, что и G-Sync, но без дорогостоящих чипов и работает на частотах от 9 до 240 Гц! Неплохо да?

Но для внедрения технологии нужно, чтобы её поддержку внедрили в прошивку и драйвер монитора, драйвер видеокарты, операционной системы и в игры!

А также необходимо наличие DisplayPort версии не ниже 1.2a, так как технология стала частью именно Display Port. Как видите, чтобы технология взлетела, нужно было проделать много работы. И этой работой занималась компания AMD.

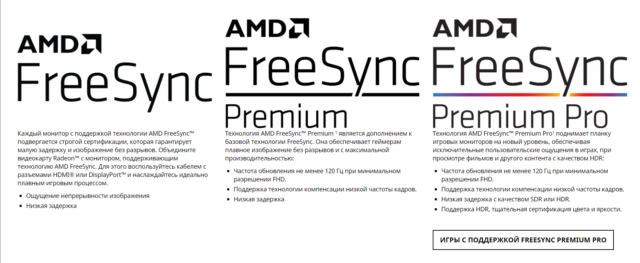

AMD FreeSync

В 2015 году AMD внедрили Adaptive Sync в драйвера своих видеокарт и назвали технологию FreeSync. Реализация от AMD быстро получила очень широкое распространение. Добавить поддержку FreeSync в монитор оказалось настолько дешево, что сейчас сложнее найти игровой монитор без этой фичи, чем с ней.

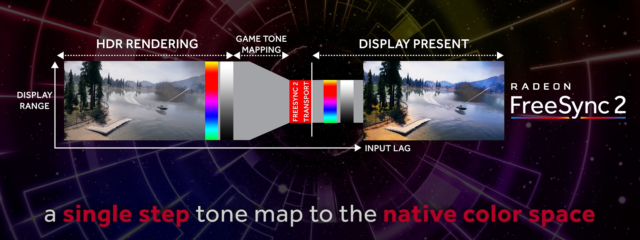

Но AMD не остановились на просто внедрении стандарта от VESA. Также они добавили поддержку HDMI, начиная с версии 1.4. А в 2017 выпустили FreeSync 2, в который добавилась поддержка HDR и компенсацию низкой частоты кадров, как в G-SYNC.

Кстати, чуть позже, FreeSync 2 переименовали в более элитное FreeSync Premium Pro, а обычный FreeSync для мониторов с частотой 120 Гц и выше стали называть FreeSync Premium. Хотя такие маркетинговые финты я не одобряю, но в остальном сплошной респект AMD за популяризацию стандарта.

Кстати, NVIDIA также в 2017 году добавила поддержку HDR и назвала это всё G-Sync Ultimate.

И вроде бы всё классно, в команде у красных и у зеленых есть по своей шикарной технологии. Но что делать, если у тебя видеокарта от NVIDIA, ты хочешь нормальную поддержку G-Sync, но покупать дорогущий монитор с этой технологией совсем не хочется? Или наоборот — не покупать же Radeon только потому что у тебя монитор с FreeSync?

До недавнего времени выбора не было никакого. Хочешь подешевле и побольше выбор мониторов — покупай Radeon. В другом случае, придется раскошелиться.

G-Sync Compatible

Но в 2019 году NVIDIA пошли навстречу покупателям и добавили поддержку стандарта VESA Adaptive Sync в драйвера для своих видеокарт серии RTX, а также для карточки GTX 1080. А значит теперь можно легко насладиться лучшим из двух миров: взять себе карточку от NVIDIA и монитор с FreeSync по вкусу. Вот только есть проблема. Если на FreeSync мониторе не написано G-Sync Compatible — значит он не был протестирован NVIDIA на совместимость и никаких гарантий, что всё будет работать нормально, вам никто не даёт. А NVIDIA тестирует далеко не все, и далеко не самые доступные модели.

Поэтому инициативу по тестированию в свои руки взяло интернет-сообщество. Они составили табличку с огромным списком протестированных пользователями мониторов.

VRR

С мониторами, кажется, разобрались. Но как быть, если хочется поиграть на большом экране телевизора через консоль или ПК. Будет ли работать адаптивная синхронизация? Спешу вас порадовать — будет! При условии что ваш ТВ оснащен портом HDMI версии 2.1, в который добавили технологию переменной частоты обновления VRR — Variable Refresh Rate.

Причём всё будет работать и с видеокартами от NVIDIA и с Radeon. Всё потому, что VRR — это та же самая технология VESA Adaptive Sync, но теперь она стала ещё и частью стандарта HDMI 2.1. Именно таким образом адаптивная синхронизация реализована в консолях нового поколения. А также, вы удивитесь, в Xbox One S и One X. Да, в коробки текущего поколения от Microsoft VRR завезли даже раньше, чем HDMI 2.1.

Итоги

Что, в итоге спустя 6 лет после своего появления, технология Adaptive Sync стала фактически отраслевым стандартом. Захватив видеокарты от AMD и NVIDIA, телевизоры и даже интегрированная графика от Intel в 11-м поколении процессоров теперь поддерживает эту технологию. А это значит, что в светлом будущем мы будем жить без единого разрыва, по крайней мере, вертикального!

- Блог компании Droider.Ru

- Компьютерное железо

- Мониторы и ТВ

- Настольные компьютеры

- Игры и игровые консоли

Источник: habr.com